Waarom je afgeronde experimenten niet in de standaard Google rapporten analyseert

Nu de gratis A/B testing tool Google Optimize voor iedereen beschikbaar is zal er hopelijk nog meer getest en geleerd worden. Er is al veel geschreven over de nieuwe tool, maar de meeste reviews en artikelen gaan voornamelijk in op de werking van de tool in vergelijking met andere A/B testing tools. Een van de veelgenoemde voordelen van Google Optimize is de feilloze verbinding met Google Analytics. Om dit te testen ga ik in dit artikel in op de analyse van A/B testen.

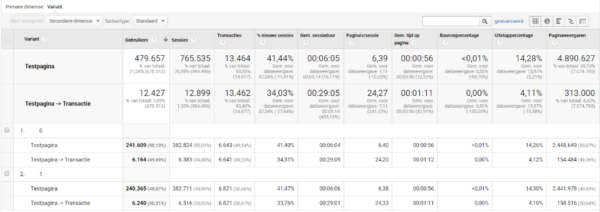

Er zijn twee standaard rapporten waarin afgeronde testen geanalyseerd kunnen worden: het Google Optimize rapport en het Google Analytics Experiment rapport. Een voordeel van het Google Optimize rapport is dat het de Bayesiaanse kans op een winnaar aangeeft. Het Analytics Experimenten rapport biedt daarentegen de mogelijkheid om één segment te selecteren zodat je dieper in de resultaten kunt duiken. Maar beide rapporten zijn erg summier en bevatten alleen het broodnodige: de totaal sessies en de hoeveelheid behaalde doelen per variant. Er wordt bijvoorbeeld niet gekeken naar de impact van een test op de gemiddelde tijd of het uitstappercentage op een pagina. Maar de twee voornaamste problemen zijn de verschillen tussen de experiment sessies van Google Optimize en Analytics en de manier waarop experiment sessies worden gebruikt.

Het verschil tussen Google Optimize en Analytics

Voordat ik dieper in het verschil tussen Google Optimize en Analytics duik ben ik geïnteresseerd in de definitie van een ‘experiment sessie’ zoals deze geformuleerd wordt door Google Optimize en Google Analytics. Deze lijken op papier hetzelfde, maar in de praktijk is er wel degelijk een verschil: de aantallen zijn gemiddeld 1% tot 2% hoger in Google Analytics. Bij testen die minder dan een week hebben gelopen lijkt dit verschil veel groter en zie je in Google Analytics zelfs tot 6%(!) extra bezoekers en transacties*. Dit kan grote gevolgen hebben. Je kunt bijvoorbeeld een winnende variatie afkeuren doordat je de verkeerde analysemethode gebruikt.

*Voor de bovenstaande data heb ik naar de resultaten van 27 uiteenlopende testen gekeken in Google Optimize en Google Analytics.

Google geeft zelf een aantal redenen voor het verschil tussen de twee tools:

- In Analytics worden de daadwerkelijke conversie percentages gerapporteerd, terwijl er in Optimize-rapporten gebruik wordt gemaakt van gemodelleerde conversiepercentages.

- De rapportvertragingen tussen de twee producten verschillen (Analytics is sneller dan Optimize).

- De sessies die net voor het einde van een experiment worden verzameld, worden niet doorgestuurd naar Optimize, maar worden wel weergegeven in Analytics.

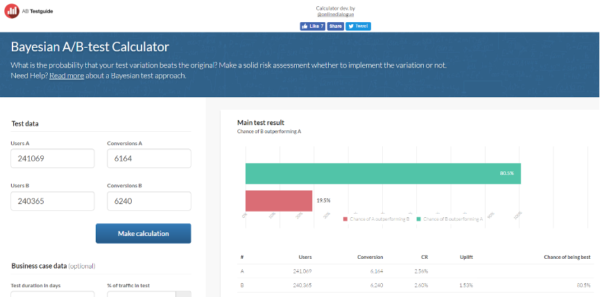

De laatste reden verklaart ook het grotere verschil bij testen die maar een aantal dagen hebben gelopen. Dit alles lijkt mij voldoende bewijs om je testen niet in Google Optimize te analyseren maar in Google Analytics. Helaas mis je dan wel de Bayesiaanse kans op een winnaar die in de tool verwerkt is, maar gelukkig zijn er genoeg Bayesiaanse calculators beschikbaar (bijvoorbeeld AB testguide).

Het gebruik van experiment sessies

Naast het niet overeenkomen van de Google Optimize en Analytics data analyseer ik vrijwel altijd gebruikers in plaats van sessies/experiment sessies. Bij een op sessie gebaseerde analyse ligt de focus op de korte termijn, maar veel producten hebben een aankoopproces van meerdere sessies die je misloopt als je op basis van sessies analyseert. Ook brengt een ‘op sessie gebaseerde analyse’ statistische problemen met zich mee omdat het conversiepercentage dan een stuk lager is, deze blog van Hubert Wassner gaat hier dieper op in. Daarnaast is Bayesiaanse statistiek gebaseerd op twee waardes: 0 en 1 oftewel, wel of niet gekocht. Als je sessies meet betekent dit dat een bezoeker meerdere keren iets kan kopen. Maar je wilt alleen kijken of een bezoeker converteert, los van hoe vaak er iets gekocht wordt.

De juiste manier om Google Optimize testen te analyseren

Op basis van de bovenstaande bevindingen heb ik kort samengevat wat de beste manier is om met Google Optimize je experimenten te analyseren:

1. Ten eerste raad ik aan al je testen in Google Analytics te analyseren omdat hier meer data sneller in wordt gerapporteerd.

2. Daarnaast kun je het beste werken met een aangepast rapport met als dimensie: experiment naam en variant, als metric gebruikers en andere interessante metrics zoals transacties, tijd op pagina of uitstappercentage. Een aangepast rapport geeft je ook de mogelijkheid om gemakkelijk te segmenteren door een secundaire dimensie en segmenten toe te voegen. Hieronder een voorbeeld van het aangepaste Google Analytics rapport dat ik gebruik bij het analyseren van de Google Optimize testen (hierbij is 0 de control en 1 de variant).

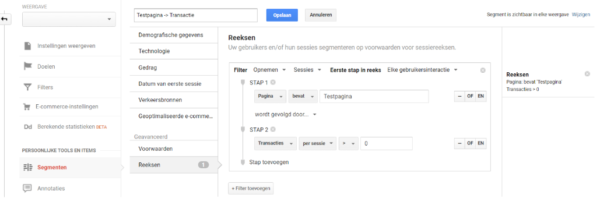

3. Gebruikers analyseren die iets hebben gedaan. Als je gebruik maakt van een frequentistische of Bayesiaanse calculatie om een winnaar te bepalen moet je gebruikers analyseren die iets wel of niet hebben gedaan. Dus dan kun je als conversiedoel geen transacties (of een andere metric) gebruiken, maar moet je gebruikers met een transactie (of een ander doel) analyseren. Om deze data tevoorschijn te toveren moet je een reeks segmenten aanmaken waarbij de bezoeker een actie uitvoert.

Het doel van de voorbeeldtest is om het aantal transacties te verhogen vanaf de testpagina. Het segment ziet er dan al volgt uit:

Als je de gebruikers zonder transactie en de gebruikers met een transactie per variant in een Bayesiaanse calculator invoert dan heeft de B variant vanaf de testpagina een kans van 80,5% op een hoger conversiepercentage dan het origineel. Afhankelijk van hoeveel risico je wilt nemen kun je er dan voor kiezen om de variant te implementeren. Daarnaast zien we dat de test waarschijnlijk weinig invloed heeft gehad op het gedrag van de bezoeker omdat de gemiddelde tijd op de pagina en het bouncepercentage ongeveer hetzelfde is gebleven.

Reacties (3)